Windows本地部署Coze

- AI Tool

- 2025-10-23

- 30热度

- 0评论

文章内容

- Coze vs N8N vs Dify 分析

- 本地部署Coze的准备工作

- 获取Coze源码

- 本地部署流程——使用火山引擎模型

- 本地部署流程——使用本地Ollama

- 测试本地模型调用

Coze vs N8N vs Dify 分析

| 对比维度 | n8n | Dify | Coze |

|---|---|---|---|

| 核心定位 | 开源工作流自动化平台,专注于跨系统集成与API连接 | AI应用开发平台,专注于LLM应用的全生命周期管理(RAG、Agent、LLMOps) | 零代码智能体开发平台,快速构建对话机器人并发布至社交平台 |

| 核心功能 | 节点式流程编排、400+应用集成、自定义JavaScript/Python代码 | 可视化Prompt编排、多模型支持、知识库管理、Agent工作流、LLMOps监控 | 拖拽式Bot搭建、多模态插件、知识库、长期记忆、定时任务 |

| 开源情况 | 核心代码开源(Apache 2.0),企业版需付费 | 核心开源(Fair Code 协议),企业版闭源 | 核心开源(Apache 2.0 + 附加协议),企业版提供高级功能(定制报价) |

| 部署方式 | 支持自托管(Docker/K8s)及云托管 | 支持自托管(需配置模型资源)及云服务 | 支持自托管(Docker/K8s)及云托管 |

| 成本模型 | 社区版免费;企业版按用户或执行次数收费 | 开源版免费;企业版按需付费(模型调用、私有部署) | 免费额度+付费订阅(按调用量或功能分级) |

| 技术门槛 | 高(需API/JavaScript基础,适合开发者) | 中(需理解AI概念,适合技术团队) | 低(零代码,适合非技术人员) |

| 优势 | 集成能力强、数据自主可控、高度灵活 | 企业级RAG精度高、多模型热切换、生产级稳定性 | 字节生态集成、开发速度快、模板丰富 |

| 局限 | AI功能需插件扩展、中文资源少 | 学习曲线陡峭、模型调用成本自负 | 知识库能力较弱、自定义能力有限 |

| 典型场景 | 数据同步、IT自动化、跨系统业务流程 | 智能客服、知识库问答、内容生成工具 | 社交媒体机器人、轻量级客服、个人助手 |

准备工作

开启Windows功能

设置路径:控制面板-程序-启用或关闭Windows功能

勾线以下功能:

- Hyper-V

- Windows虚拟机监控程序平台

- 容器

- 适用于Linux的Windows子系统

安装Git

下载地址:https://git-scm.com/install/windows

注意:

- 选择 “Git for Windows/x64 Setup”

安装Docker

下载地址:https://www.docker.com/

注意:

- Windows平台需要区分AMD64 和 ARM64

- Docker安装完成后会强制系统重新启动

- 重启后第一次启动Docker会自动下载wsl

- 下载镜像前先修改本地镜像储存位置

- 设置路径:DockerDesktop - 设置(右上角齿轮图标) - Resources - Disk image location

- 点击 Browse 选择新的储存位置

获取源码

从 GitHub 克隆仓库

git clone https://github.com/coze-dev/coze-studio.git国内用户可使用镜像加速

git clone https://gitee.com/mirrors_coze/coze-studio.git本地部署流程

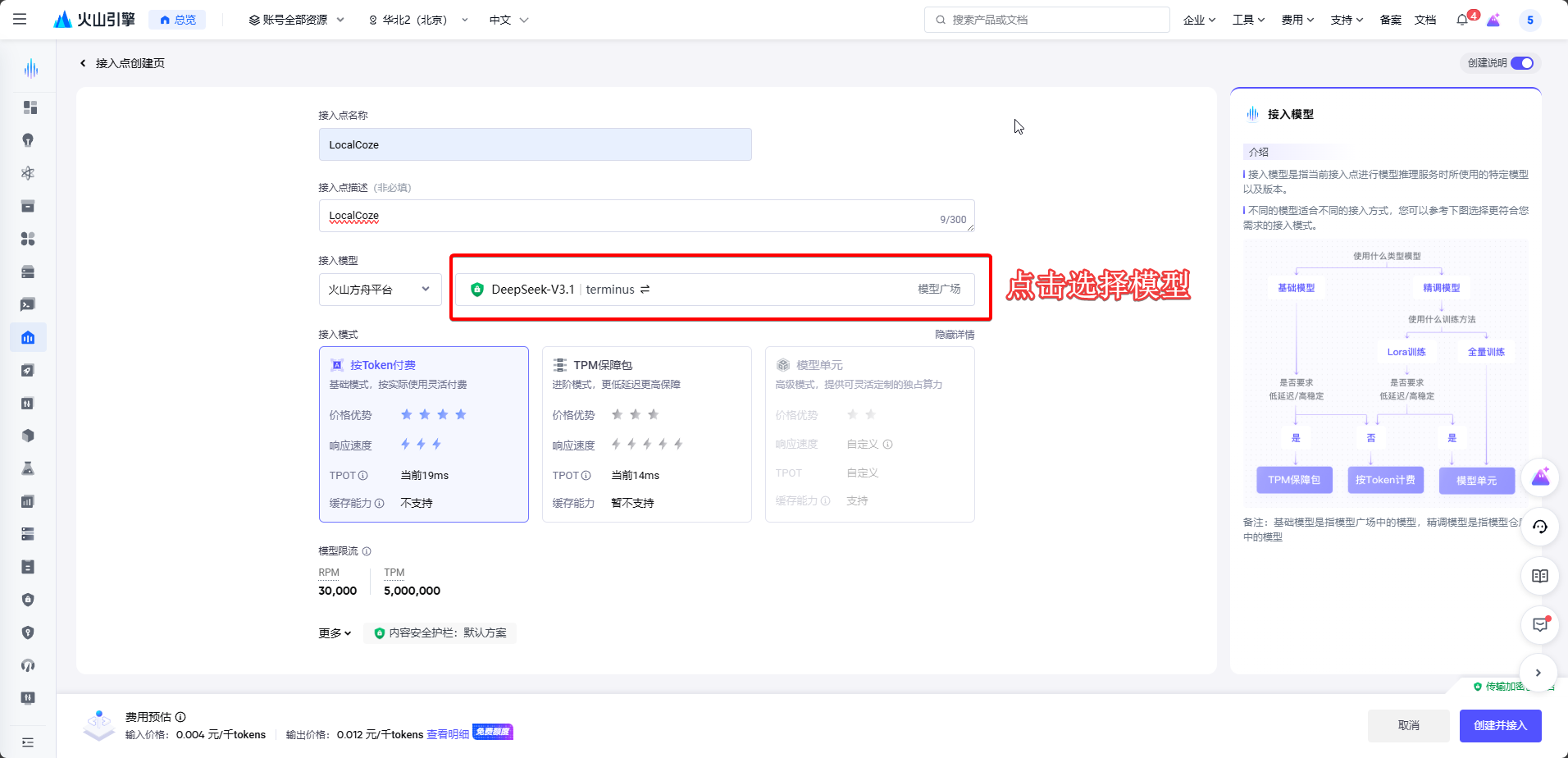

方案一:使用火山引擎模型

1.登录火山引擎控制台,进入火山方舟 → API Key 管理创建 API Key。

2.在在线推理页面创建自定义推理接入点,选择目标模型(如DeepSeek-V3.1),获取 Endpoint ID。

3.重命名配置文件

将coze-studio\docker\.env.example 为 coze-studio\docker\.env

4.根据需要修改docker-compose(修改完成后务必需要符合yaml语法格式)

# 修改MYSQL端口,将默认的3306修改为其他端口(可选)

# 需要去除行首注释

ports:

- '33060'5.复制模型模板文件(修改完成后务必需要符合yaml语法格式)

- 进入模型目录

coze-studio\backend\conf\model\template - 随便选一个模型,比如我这里选择

model_template_ark_volc_deepseek-v3.yaml - 将此文件复制到

coze-studio\backend\conf\model\ - 修改

model_template_ark_volc_deepseek-v3.yaml中的ID和KEY

api_key: "填入在浏览器注册的AEY"

model: "填入在浏览器注册的ID(ep- 开头的字符串)" # model_id / endpoint_id启动集群

- 进入目录

coze-studio\docker - 在地址栏输入CMD启动命令提示符

# 启动

docker compose --profile '*' up -d

# 如果需要停止可以使用

# docker compose down

# 或

# docker compose down -v登陆WEB

- 浏览器访问 http://127.0.0.1:8888/

- 输入邮箱和密码,点击注册

方案二:使用本地Ollama

假设你已经安装完成Ollama 如果没有安装参考此文章 Windows 中部署Ollama和常用命令

查看ollama模型

ollama list

NAME ID SIZE MODIFIED

qwen3:8b 500a1f067a9f 5.2 GB 34 minutes ago复制模型模板文件(修改完成后务必需要符合yaml语法格式)

- 进入模型目录

coze-studio\backend\conf\model\template - 选择

model_template_ollama.yaml - 将此文件复制到

coze-studio\backend\conf\model\ - 将

model_template_ollama.yaml修改为model_template_ollama-qwen3-8b.yaml - 修改

model_template_ollama-qwen3-8b.yaml中的id、name、model

id: 1001 #(必须修改)此处需修改为全局唯一,且不为0的正整数

name: qwen3:8b #(可选修改) 修改为一个在coze中可以直接查看的名称

icon_uri: default_icon/ollama.png

icon_url: ""

description:

zh: ollama 模型简介

en: ollama model description

default_parameters:

- name: temperature

label:

zh: 生成随机性

en: Temperature

desc:

zh: '- **temperature**: 调高温度会使得模型的输出更多样性和创新性,反之,降低温度会使输出内容更加遵循指令要求但减少多样性。建议不要与“Top p”同时调整。'

en: '**Temperature**:\n\n- When you increase this value, the model outputs more diverse and innovative content; when you decrease it, the model outputs less diverse content that strictly follows the given instructions.\n- It is recommended not to adjust this value with \"Top p\" at the same time.'

type: float

min: "0"

max: "1"

default_val:

balance: "0.8"

creative: "1"

default_val: "1.0"

precise: "0.3"

precision: 1

options: []

style:

widget: slider

label:

zh: 生成多样性

en: Generation diversity

- name: max_tokens

label:

zh: 最大回复长度

en: Response max length

desc:

zh: 控制模型输出的Tokens 长度上限。通常 100 Tokens 约等于 150 个中文汉字。

en: You can specify the maximum length of the tokens output through this value. Typically, 100 tokens are approximately equal to 150 Chinese characters.

type: int

min: "1"

max: "4096"

default_val:

default_val: "4096"

options: []

style:

widget: slider

label:

zh: 输入及输出设置

en: Input and output settings

meta:

protocol: ollama

capability:

function_call: true

input_modal:

- text

input_tokens: 128000

json_mode: false

max_tokens: 128000

output_modal:

- text

output_tokens: 16384

prefix_caching: false

reasoning: false

prefill_response: false

conn_config:

base_url: "http://host.docker.internal:11434" #(不用修改)

api_key: "" # (不用修改)

timeout: 0s

model: "qwen3:8b" #(必须修改)ollama list中的模型名称

temperature: 0.6

frequency_penalty: 0

presence_penalty: 0

max_tokens: 4096

enable_base64_url: false

top_p: 0.95

top_k: 20

stop: []

custom: {}

status: 0启动集群

- 进入目录

coze-studio\docker - 在地址栏输入CMD启动命令提示符

# 启动

docker compose --profile '*' up -d

# 如果需要停止可以使用

# docker compose down

# 或

# docker compose down -v登陆WEB

- 浏览器访问 http://127.0.0.1:8888/

- 输入邮箱和密码,点击注册

测试本地模型调用

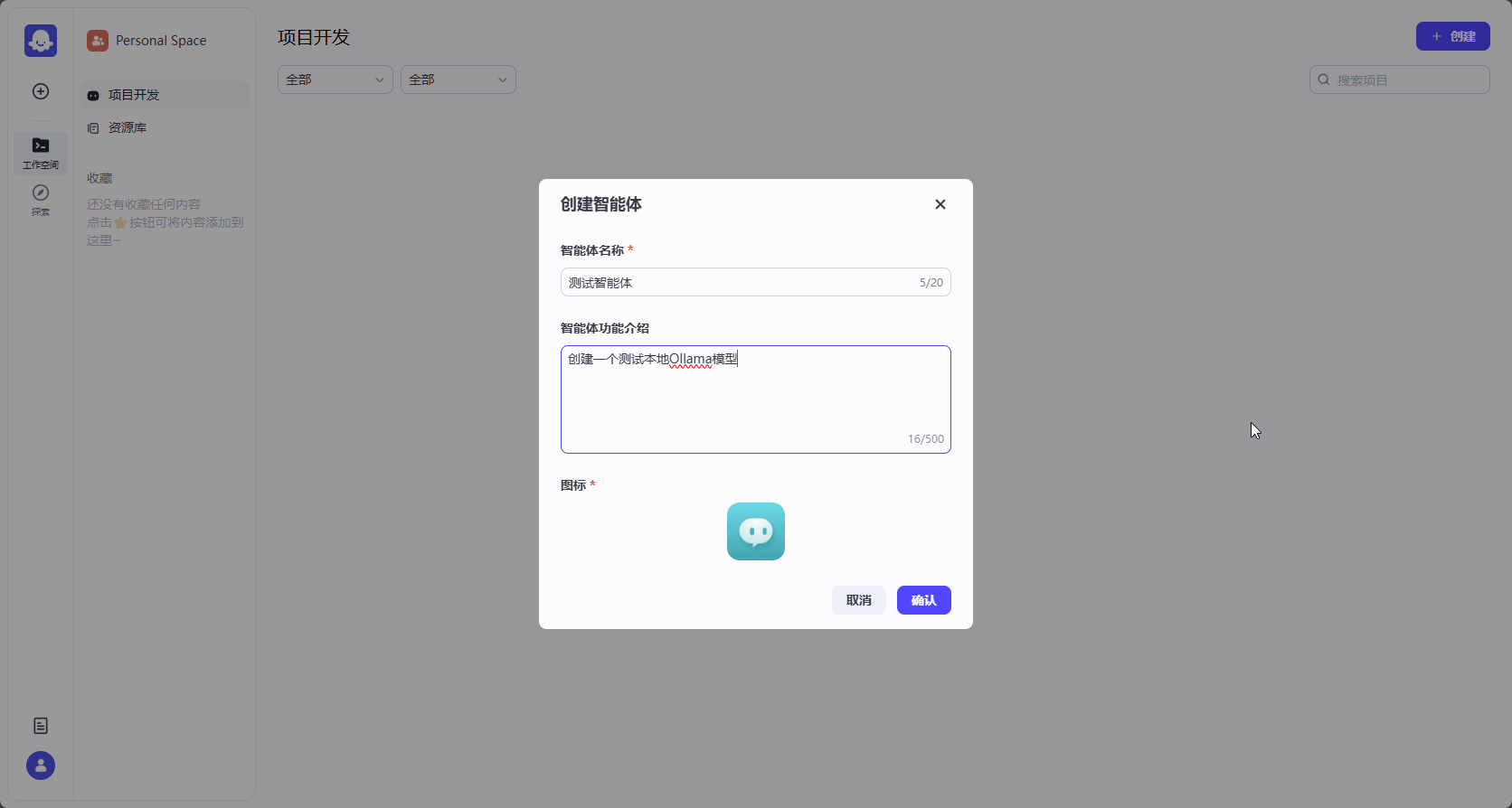

1. 创建智能体

2. 设置智能体名称和简介

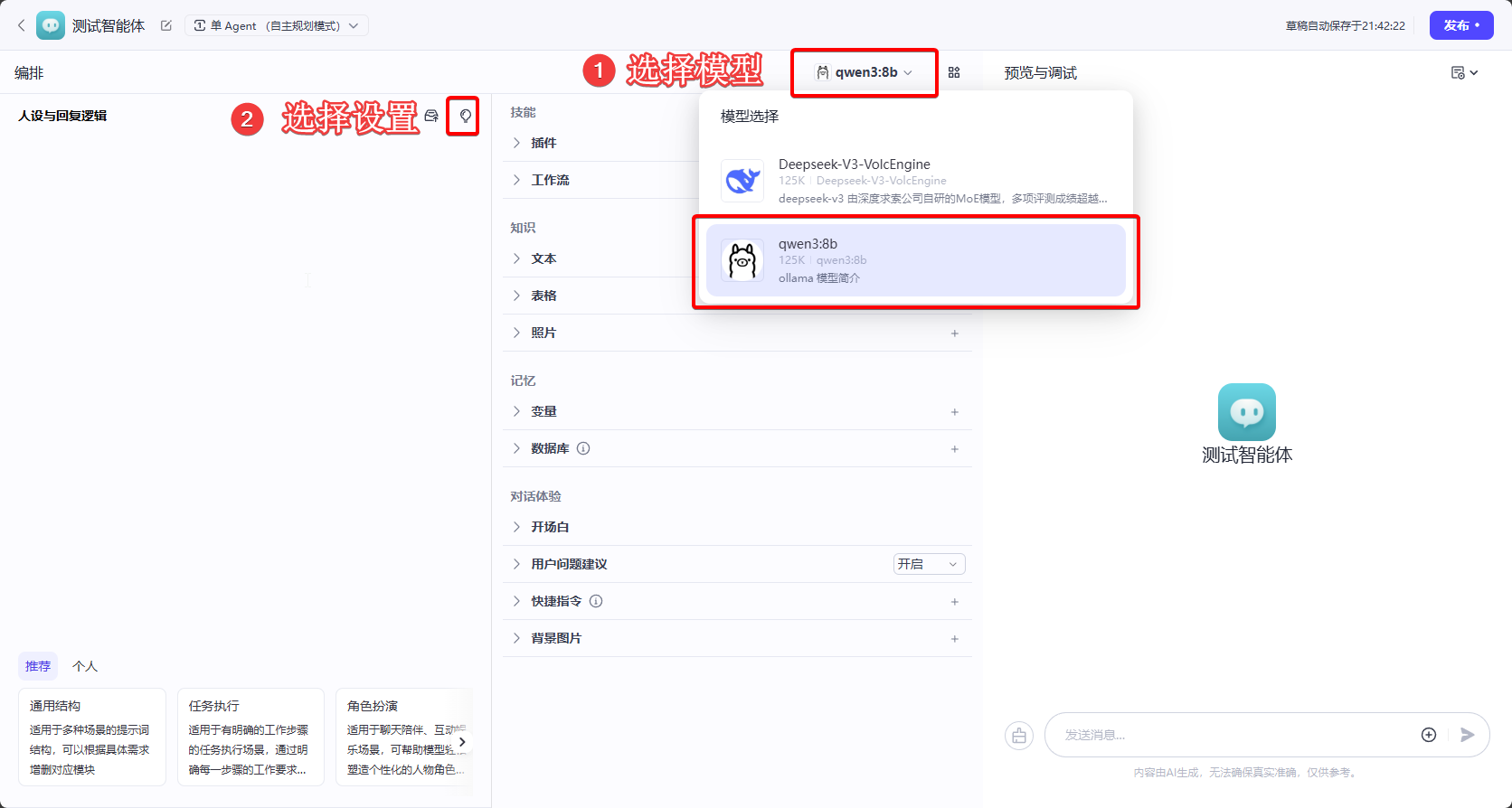

3. 选择本地模型

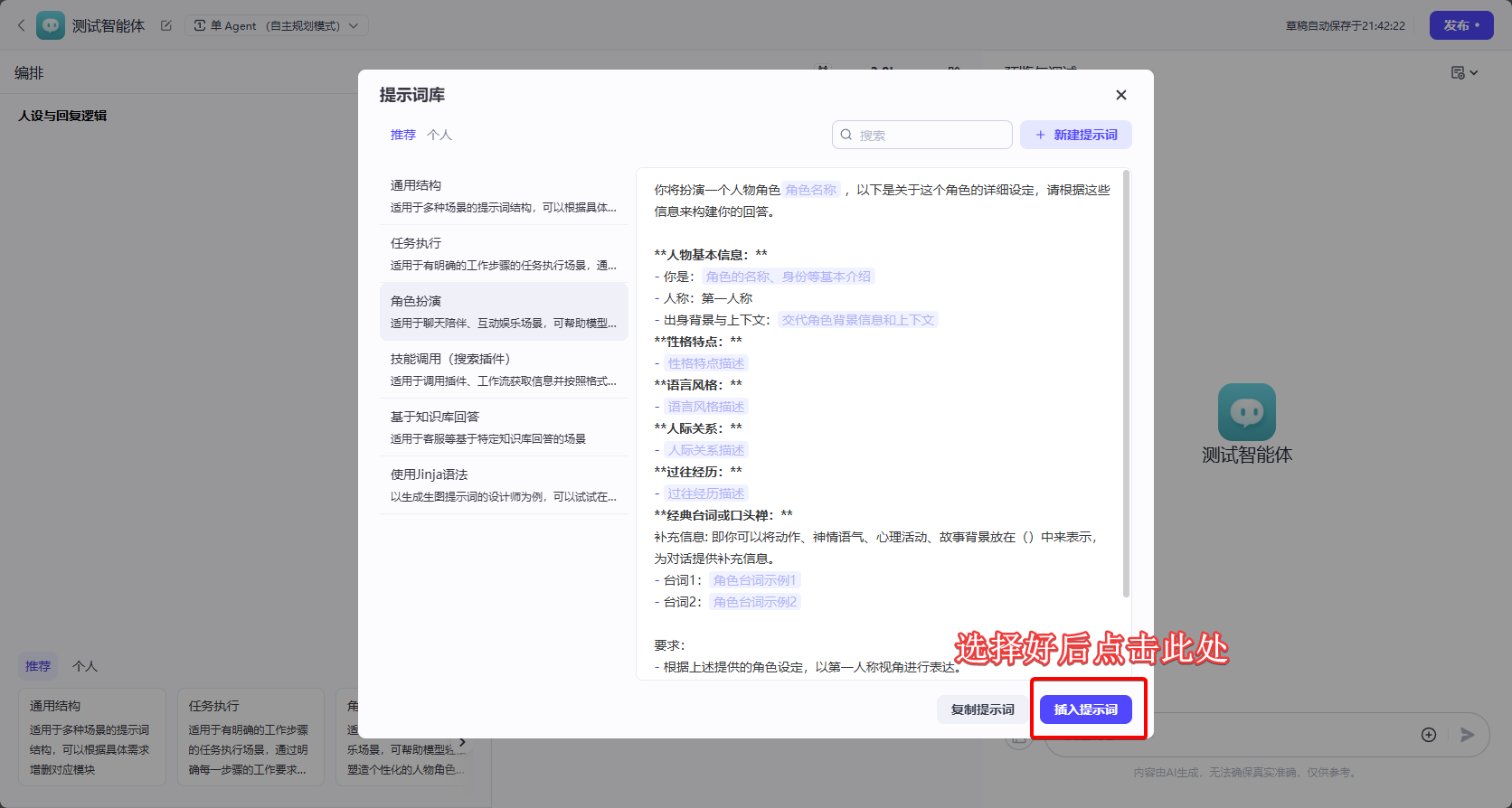

4. 使用默认提示词库

5. 预览与调试