Windows本地部署n8n

- AI Tool

- 2025-10-25

- 46热度

- 0评论

文章内容

- Coze vs N8N vs Dify 分析

- 本地部署n8n的准备工作

- 获取n8n和配置

- 初始化配置

- 本地模型测试

Coze vs N8N vs Dify 分析

| 对比维度 | n8n | Dify | Coze |

|---|---|---|---|

| 核心定位 | 开源工作流自动化平台,专注于跨系统集成与API连接 | AI应用开发平台,专注于LLM应用的全生命周期管理(RAG、Agent、LLMOps) | 零代码智能体开发平台,快速构建对话机器人并发布至社交平台 |

| 核心功能 | 节点式流程编排、400+应用集成、自定义JavaScript/Python代码 | 可视化Prompt编排、多模型支持、知识库管理、Agent工作流、LLMOps监控 | 拖拽式Bot搭建、多模态插件、知识库、长期记忆、定时任务 |

| 开源情况 | 核心代码开源(Apache 2.0),企业版需付费 | 核心开源(Fair Code 协议),企业版闭源 | 核心开源(Apache 2.0 + 附加协议),企业版提供高级功能(定制报价) |

| 部署方式 | 支持自托管(Docker/K8s)及云托管 | 支持自托管(需配置模型资源)及云服务 | 支持自托管(Docker/K8s)及云托管 |

| 成本模型 | 社区版免费;企业版按用户或执行次数收费 | 开源版免费;企业版按需付费(模型调用、私有部署) | 免费额度+付费订阅(按调用量或功能分级) |

| 技术门槛 | 高(需API/JavaScript基础,适合开发者) | 中(需理解AI概念,适合技术团队) | 低(零代码,适合非技术人员) |

| 优势 | 集成能力强、数据自主可控、高度灵活 | 企业级RAG精度高、多模型热切换、生产级稳定性 | 字节生态集成、开发速度快、模板丰富 |

| 局限 | AI功能需插件扩展、中文资源少 | 学习曲线陡峭、模型调用成本自负 | 知识库能力较弱、自定义能力有限 |

| 典型场景 | 数据同步、IT自动化、跨系统业务流程 | 智能客服、知识库问答、内容生成工具 | 社交媒体机器人、轻量级客服、个人助手 |

本地部署n8n的准备工作

开启Windows功能

设置路径:控制面板-程序-启用或关闭Windows功能

勾线以下功能:

- Hyper-V

- Windows虚拟机监控程序平台

- 容器

- 适用于Linux的Windows子系统

安装Docker

下载地址:https://www.docker.com/

注意:

- Windows平台需要区分AMD64 和 ARM64

- Docker安装完成后会强制系统重新启动

- 重启后第一次启动Docker会自动下载wsl

- 下载镜像前先修改本地镜像储存位置

- 设置路径:DockerDesktop - 设置(右上角齿轮图标) - Resources - Disk image location

- 点击 Browse 选择新的储存位置

获取n8n和配置

通过Docker是最方便的方式

或者访问 n8n 中文社区 下载适配 Windows 10/11 的免安装版(内含 Node.js 环境)。

# 直接启动

docker run -d --name n8n -p 5678:5678 -v n8n_data:/home/node/.n8n n8nio/n8n

-p 5678:5678:将容器的5678端口映射到本机的5678端口。

-v n8n_data:/home/node/.n8n:创建名为n8n_data的Docker数据卷,用于持久化保存n8n的工作流和配置,防止容器重启后数据丢失

# 或者单独添加一个本地文件方便后期直接对本地文件进行操作

docker run -it --rm `

--name n8n `

-p 5678:5678 `

-v D:\Software\n8n\data:/home/node/.n8n `

-v D:\Software\n8n\LocalFile:/files `

n8nio/n8初始化配置

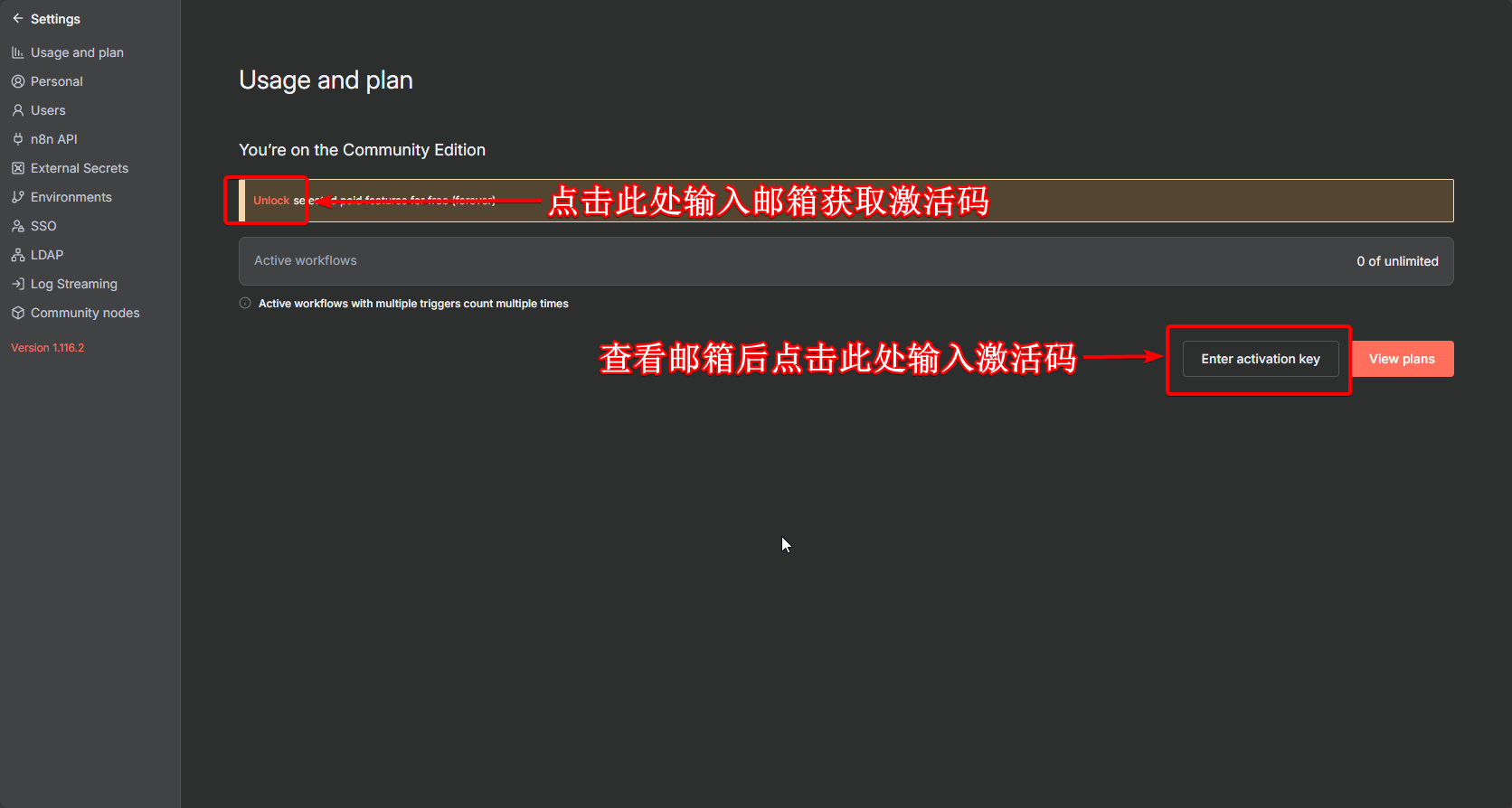

当容器运行后可以访问 http://127.0.0.1:5678/ 访问本地n8n,填写完用户名和密码剩下的都可以跳过之后在调整

- 获取激活码 访问 http://127.0.0.1:5678/settings/usage

本地模型测试

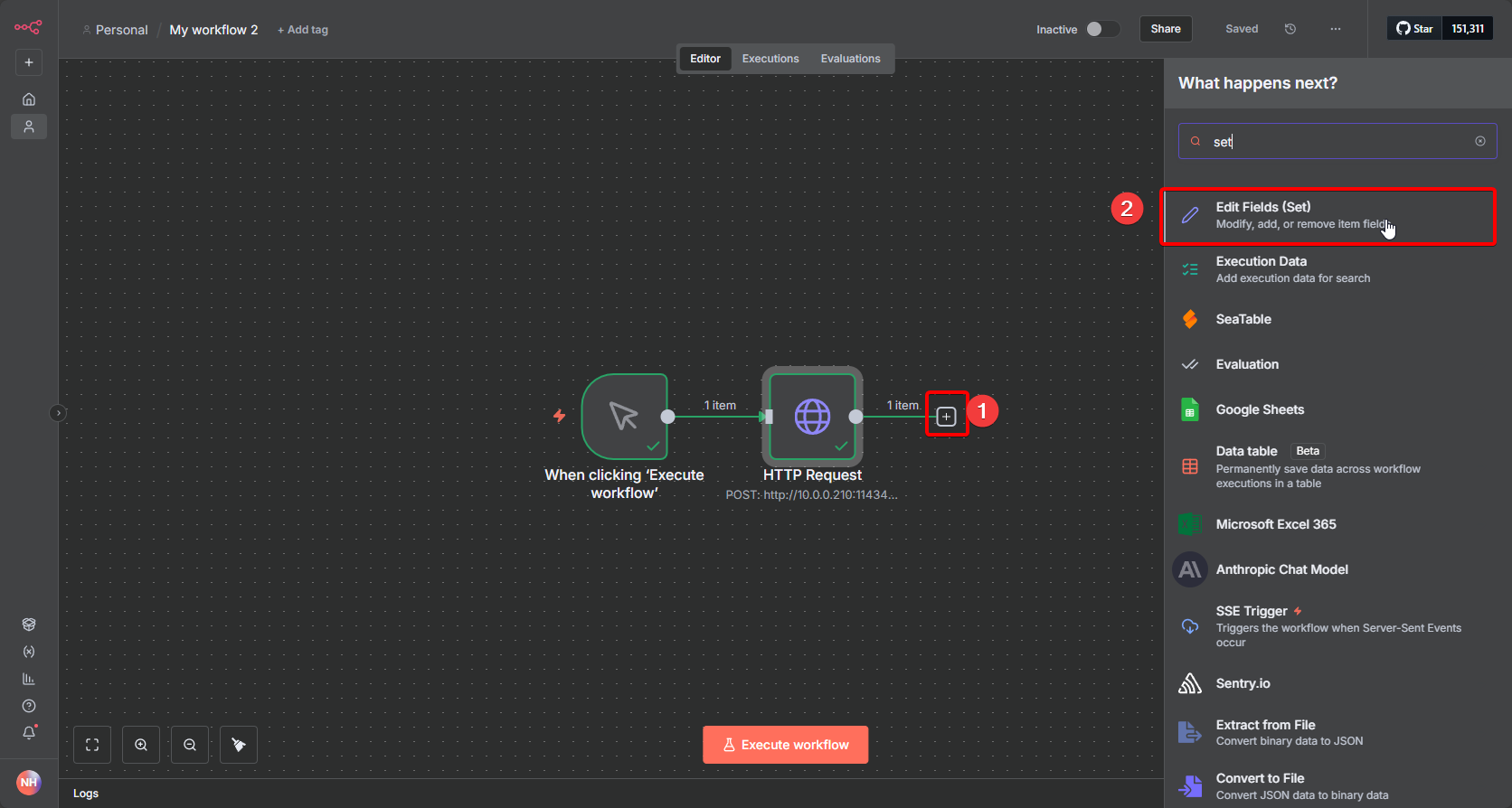

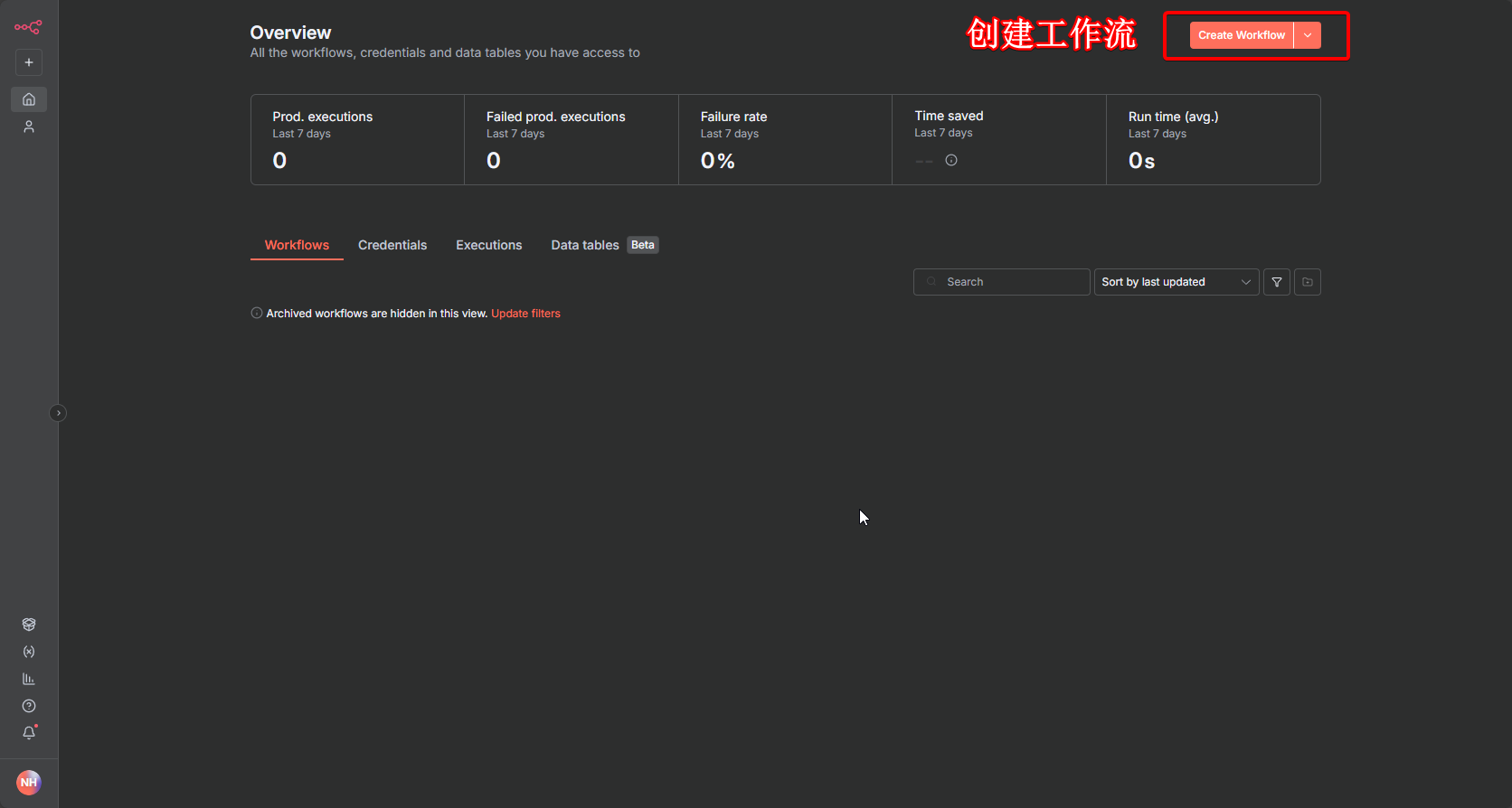

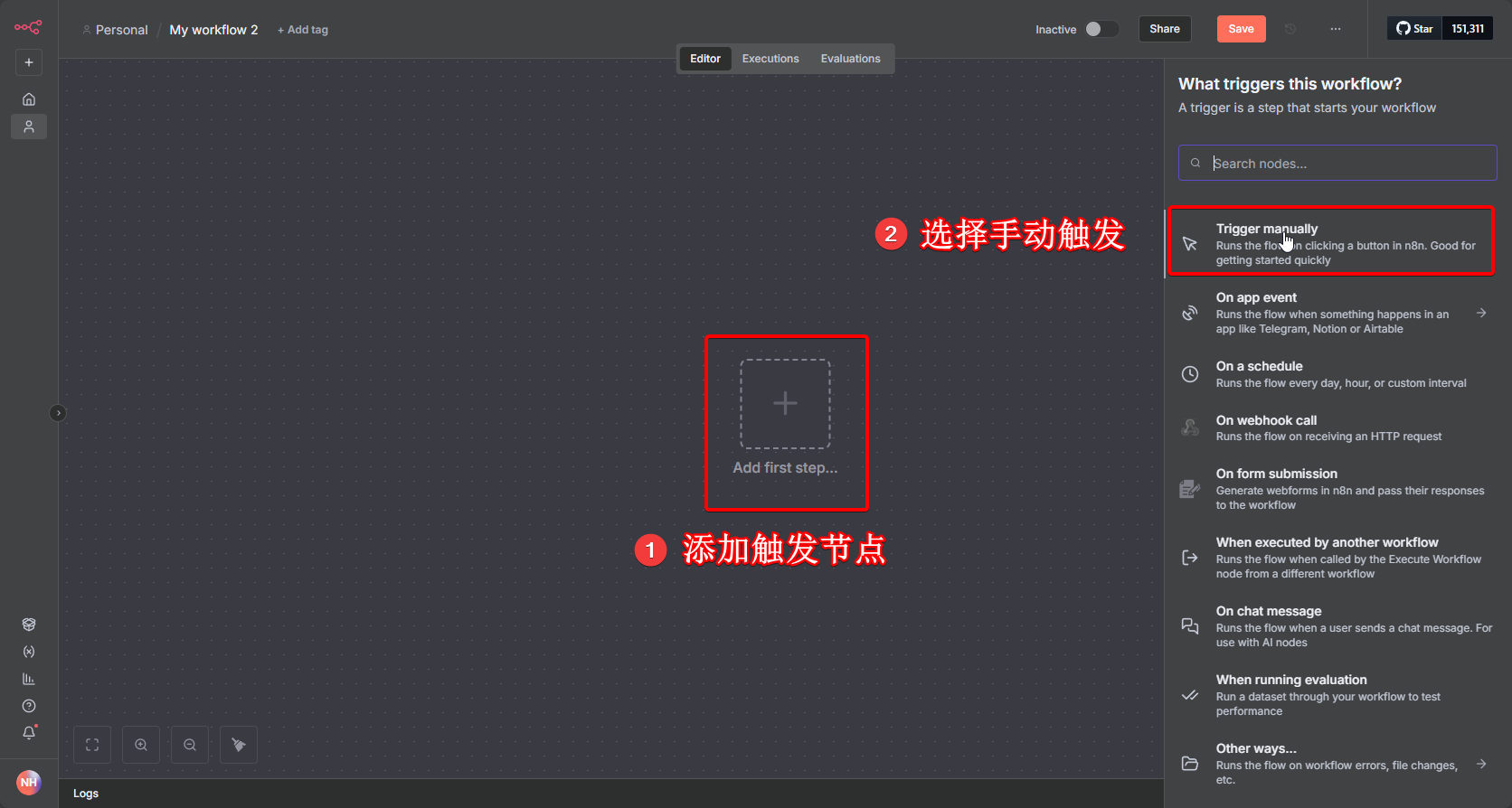

访问 http://127.0.0.1:5678/home/workflows 创建一个工作流

- 创建工作流

- 添加触发节点

根据需求选择触发方式,例如:

- Manual Trigger(手动触发,用于测试);

- Webhook(通过 HTTP 请求触发);

- Schedule(定时触发)。

这里以 “Manual Trigger” 为例,直接手动运行测试。

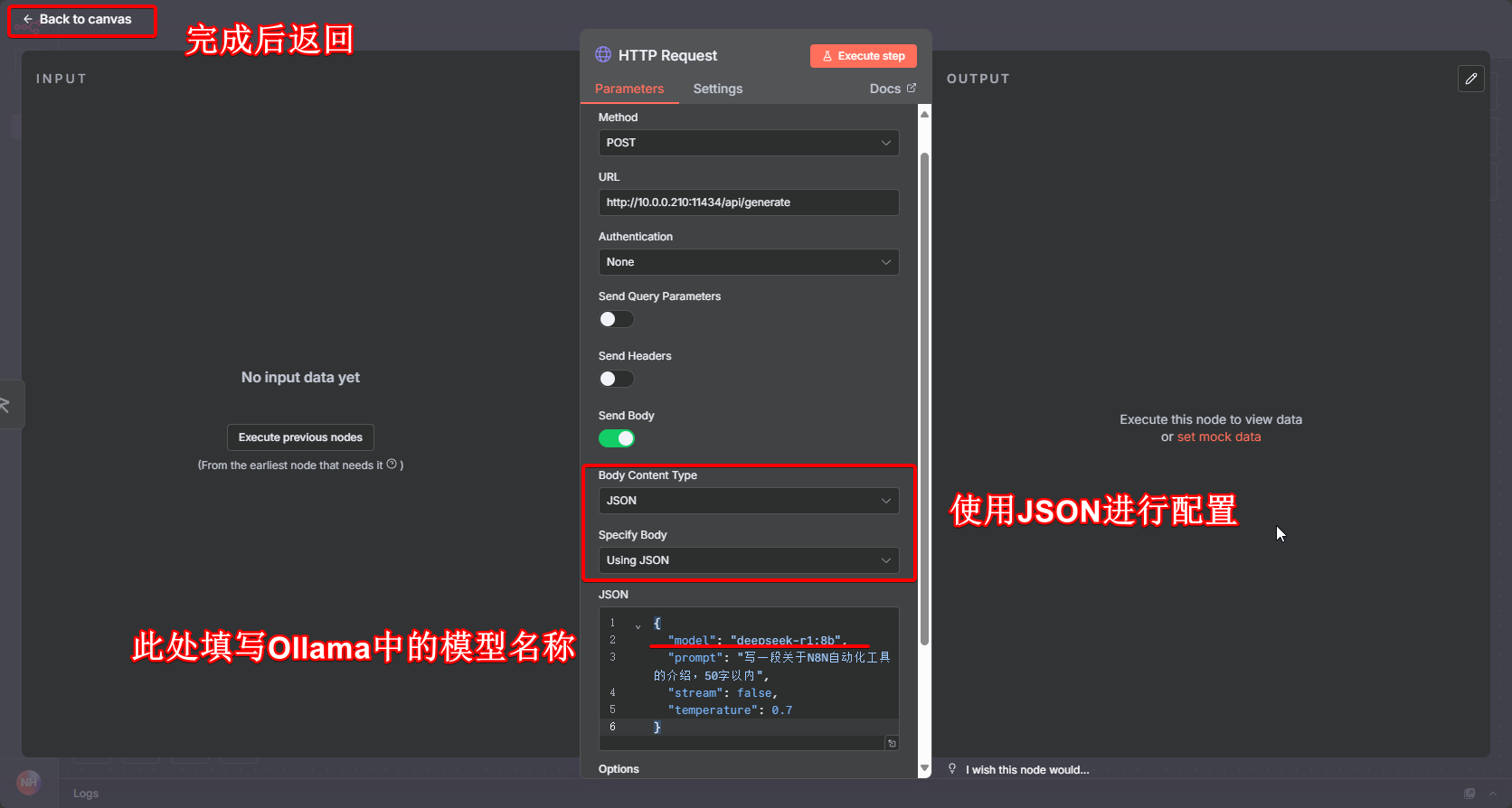

- 添加 HTTP Request 节点

- Method:选择

POST(Ollama API主要用POST请求) - URL:填写Ollama API地址:

- - 本地Ollama(N8N与Ollama在同一台机器)

http://localhost:11434/api/generate(文本生成)或http://localhost:11434/api/chat(对话交互)- 若N8N在Docker中,需用宿主机IP或

host.docker.internal代替localhost(如http://host.docker.internal:11434/api/generate) - 这里为了方便直接使用 本地IP:11434/api/generate 进行演示

适合一次性生成文本(如写文案、总结),Body 配置示例

{

"model": "deepseek-r1:8b",

"prompt": "写一段关于N8N自动化工具的介绍,50字以内",

"stream": false,

"temperature": 0.7

}- 测试当前步骤

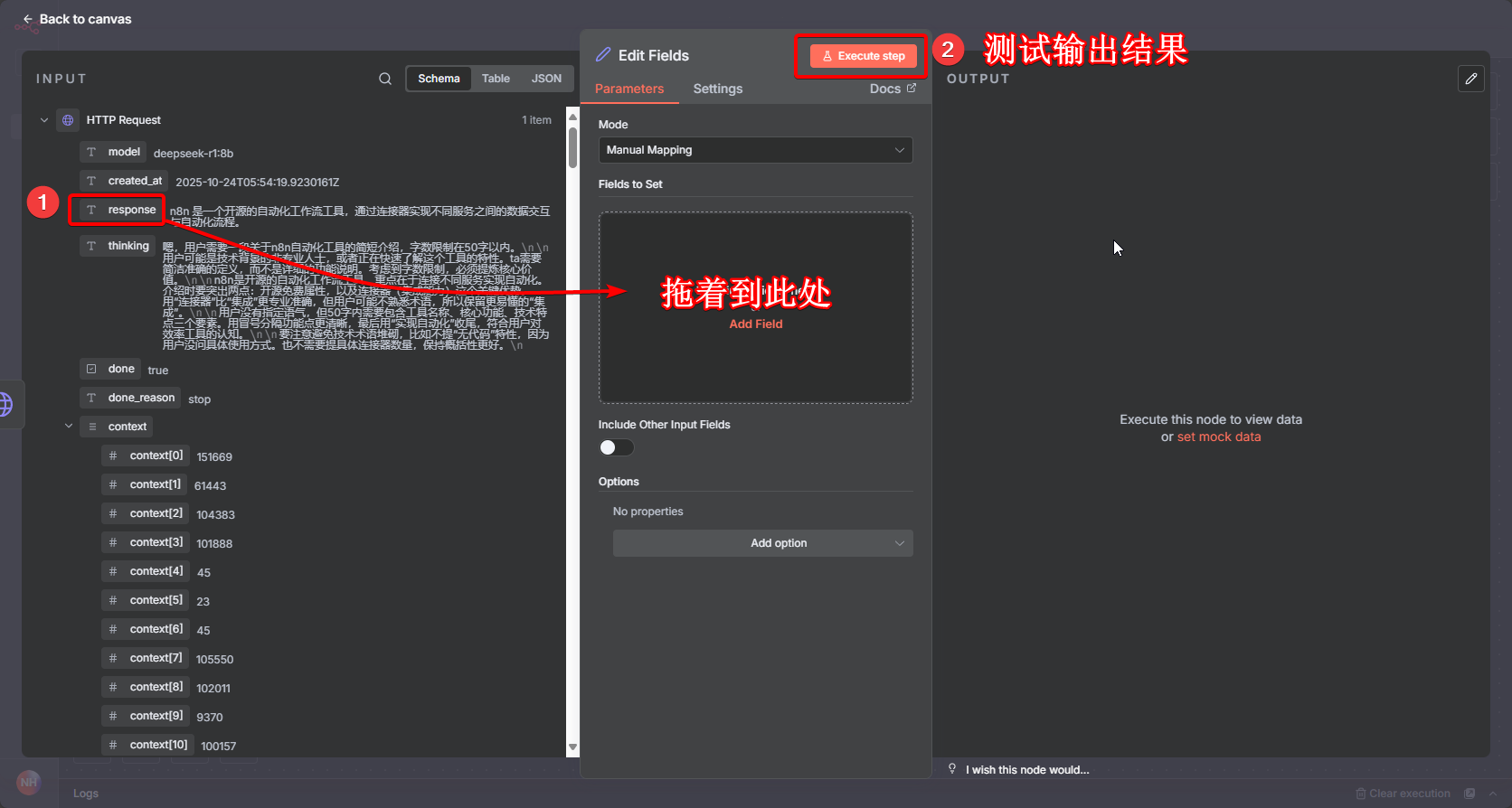

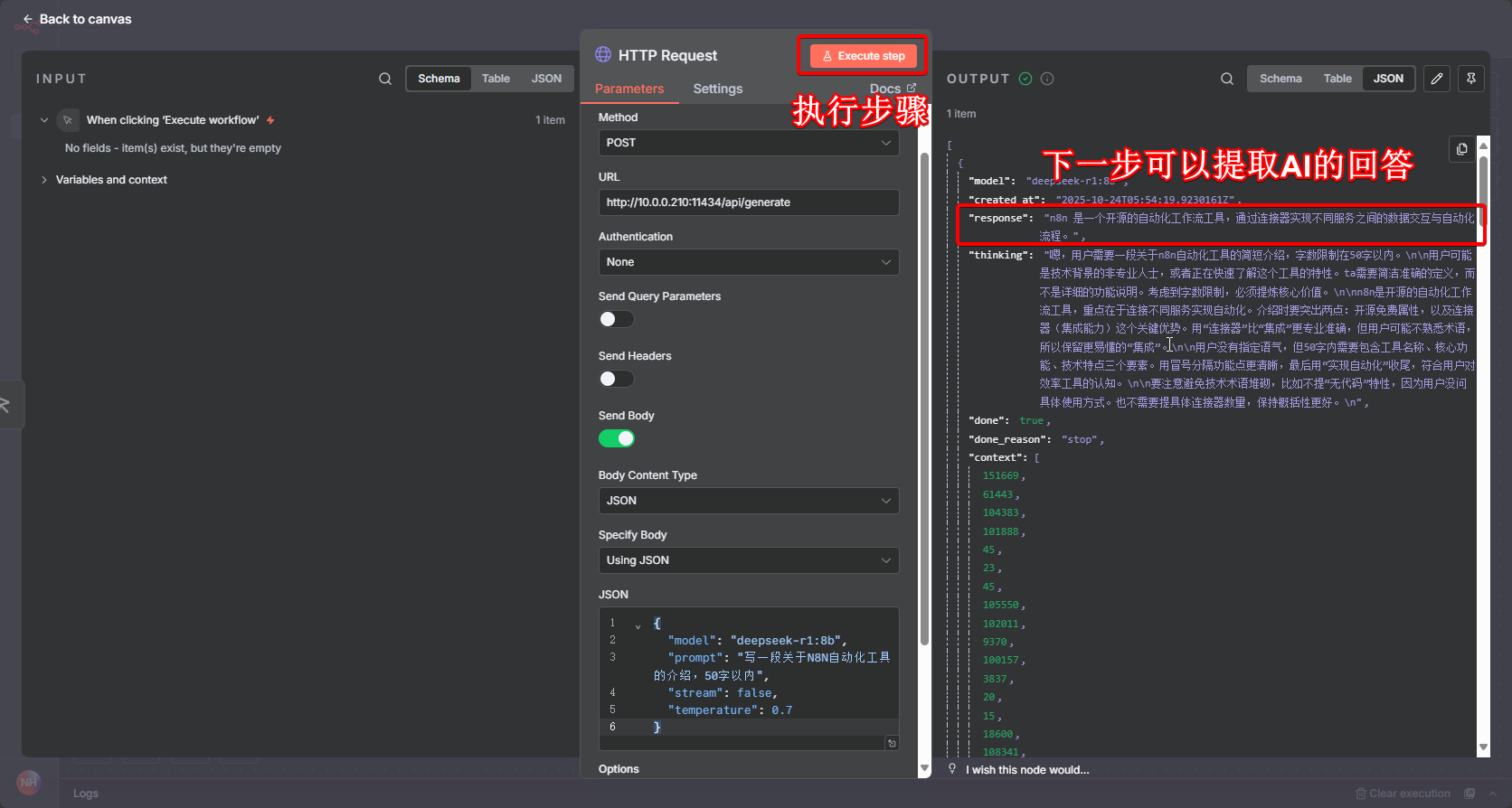

点击 HTTP Request 节点的 “执行节点”,运行后可在 “输出” 中看到 Ollama 的响应。响应格式示例(单轮生成):

"model": "deepseek-r1:8b",

"created_at": "2025-10-24T05:54:19.9230161Z",

"response": "n8n 是一个开源的自动化工作流工具,通过连接器实现不同服务之间的数据交互与自动化流程。",

......- 提取 response 字段 Set 节点(提取结果)