Windows 中部署Ollama和常用命令

- AI Tool

- 2025-10-23

- 24热度

- 0评论

文章内容

- Ollama安装

- Ollama基本使用与模型运行

- 导出Ollama下载的模型

- 导入Ollama下载的模型

Ollama安装

- 下载安装包

访问Ollama官方网站https://ollama.com ,点击页面上的 "Download for Windows" 按钮,下载名为OllamaSetup.exe的安装程序。 - 运行安装程序

(推荐使用默认安装):直接双击下载的OllamaSetup.exe文件,点击弹出的窗口中的 "Install" 按钮,安装程序将自动完成安装过程。安装完成后,Ollama服务会自动在后台启动,您可以在Windows任务栏的系统托盘区看到一个羊驼图标。 - 验证安装

安装完成后,打开一个新的命令提示符或PowerShell窗口,输入以下命令:

ollama --version

如果安装成功,命令行将显示Ollama的版本号- 修改模型存储路径

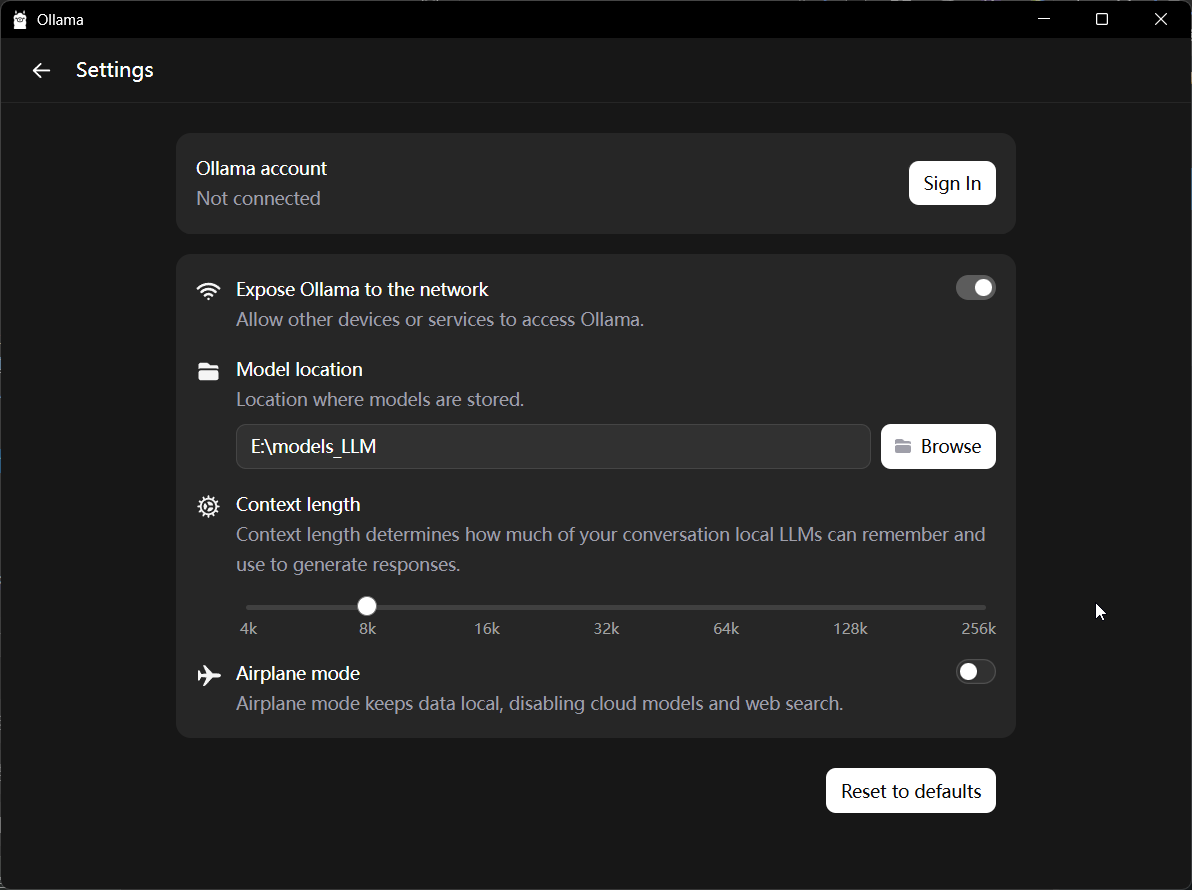

模型文件默认存储在C盘用户目录下(C:\Users\[用户名]\.ollama\models)。为避免占满系统盘空间,强烈建议将其迁移到其他分区,比如我这里选择E:\models_LLM

5.配置远程访问(可选)

如果您希望通过局域网内的其他设备访问本机的Ollama服务,需要设置环境变量。新建一个名为 OLLAMA_HOST 的系统变量,将其值设置为 0.0.0.0:11434(11434是默认端口,可更改)。请注意,此操作会开放端口,可能存在安全风险,请在可信的网络环境中使用。

Ollama基本使用与模型运行

- 运行您的第一个模型

在命令提示符中,您可以使用ollama run命令来拉取(如果本地没有则会自动下载)并运行一个模型。例如,要运行DeepSeek-R1模型,可以输入:

ollama run deepseek-r1:1.5b首次运行时会自动从官方库下载模型,下载完成后会进入交互对话界面。

- 常用管理命令

ollama list:查看本地已安装的模型列表。ollama pull <模型名>:仅下载模型而不立即运行。ollama rm <模型名>:删除指定的本地模型以释放空间。ollama cp <原模型名> <新名称>:复制一个模型并为其创建新别名。

导出Ollama下载的模型

#查看已下载的模型

ollama list

NAME ID SIZE MODIFIED

deepseek-r1:8b 6995872bfe4c 5.2 GB 20 hours ago

qwen3:8b 500a1f067a9f 5.2 GB 21 hours ago

# 定位模型位置

ollama show gemma3:12b --modelfile

# 此行会显示模型具体位置

FROM /usr/share/ollama/.ollama/models/blobs/sha256-e8ad13eff07a78d89926e9e8b882317d082ef5bf9768ad7b50fcdbbcd63748de

# 导出模型

cp /usr/share/ollama/.ollama/models/blobs/sha256-e8ad13eff07a78d89926e9e8b882317d082ef5bf9768ad7b50fcdbbcd63748de /tmp/gemma3_12b.gguf

# 导出modelfile文件

ollama show gemma3:12b --modelfile > modelfile导入Ollama下载的模型

# 将GGUF文件和modelfile文件存放在一个文件夹中

pwd #查看当前路径

/tmp

ls # 查看路径下的文件

gemma3_12b.gguf modelfile

# 将modelfile中的 FROM /usr/share/ollama/.ollama/models/blobs/sha256-e8ad13eff07a78d89926e9e8b882317d082ef5bf9768ad7b50fcdbbcd63748de

# 修改为你gemma3_12b.gguf modelfile 这两个文件的当前路径+文件名

# 比如演示的 ./gemma3_12b.gguf

# 或者完整路径 /tmp/gemma3_12b.gguf

FROM ./gemma3_12b.gguf

# 导入模型

ollama create gemma3_12b.gguf -f ./modelfile

# 输出类似结果

gathering model components

copying file sha256:e8ad13eff07a78d89926e9e8b882317d082ef5bf9768ad7b50fcdbbcd63748de 100%

parsing GGUF

using existing layer sha256:e8ad13eff07a78d89926e9e8b882317d082ef5bf9768ad7b50fcdbbcd63748de

creating new layer sha256:e0a42594d802e5d31cdc786deb4823edb8adff66094d49de8fffe976d753e348

creating new layer sha256:dd084c7d92a3c1c14cc09ae77153b903fd2024b64a100a0cc8ec9316063d2dbc

creating new layer sha256:3116c52250752e00dd06b16382e952bd33c34fd79fc4fe3a5d2c77cf7de1b14b

writing manifest

success

# 查看导入结果

ollama list

NAME ID SIZE MODIFIED

gemma3_12b.gguf:latest 66991d99dc11 8.1 GB 12 seconds ago # 导入的模型

deepseek-r1:8b 6995872bfe4c 5.2 GB 20 hours ago

qwen3:8b 500a1f067a9f 5.2 GB 21 hours ago

# 测试模型

ollama run gemma3_12b.gguf:latest

>>> hello

Hello there! 👋